商机详情 -

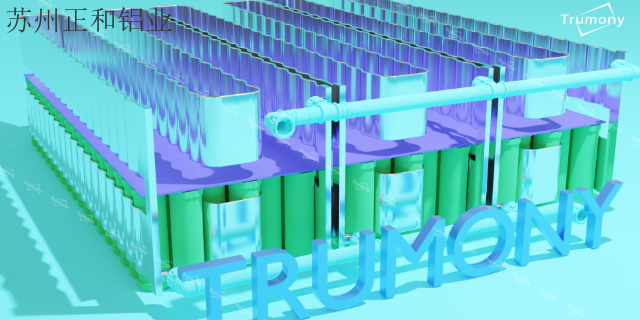

北京电池液冷供应商

近年来,我国数据中心绿色发展进程日益加快,数据中心的能效水平不断提高,电源使用效率(PowerUsageEffectiveness,PUE)持续降低。2019年年底全国现有超大型数据中心平均PUE为1.46,大型数据中心平均PUE为1.55;规划在建的超大型、大型数据中心平均设计PUE分别为1.36、1.39。根据工信部《新型数据中心发展三年行动计划(2021-2023年)》的文件,到2023年底,新建大型及以上数据中心PUE降低到1.3以下,我国绿色数据中心发展政策也指出,将计划降低数据中心能耗总体水平。在数据中心能耗占比中制冷系统的能耗占比为30-40%,是总能耗中占比高的数据中心基础设施模块,因此改进数据中心制冷等基础设施技术,提高制冷效率,减少制冷系统的能耗水平,成为未来发展方向。液冷 ,就选正和铝业,让您满意,欢迎您的来电!北京电池液冷供应商

随着人工智能、云计算、大数据以及区块链等技术的创新发展,使得数据资源的存储、计算和应用需求快速扩张,特别是ChatGPT技术推广进一步催生了AI算力等大功率应用场景加速落地。作为信息基础设施的数据中心及通信设备承担的计算量越来越大,对计算效率的要求也越来越高,国内包括全球的数据中心建设有望迎来建设高峰。为了应对网络处理性能的挑战,数据中心服务器及通信设备不断提升自身处理能力和集成度,带来了功率密度的节节攀升。这些变化除了带来巨额能耗问题以外,高热密度也给制冷设备和技术提出了更高要求。传统风冷技术面对高热密度场景呈现瓶颈,散热效率已经跟不上计算效率。在此背景下,液冷技术以其超高能效、超高热密度等特点引起行业的普遍关注,是解决散热压力和节能挑战的必由之路。品质保障液冷供应如何区分液冷的的质量好坏。

近年来,我国数据中心绿色发展进程日益加快,数据中心的能效水平不断提高,电源使用效率(PowerUsageEffectiveness,PUE)持续降低。2019年年底全国现有超大型数据中心平均PUE为1.46,大型数据中心平均PUE为1.55;规划在建的超大型、大型数据中心平均设计PUE分别为1.36、1.39。根据工信部《新型数据中心发展三年行动计划(2021-2023年)》的文件,到2023年底,新建大型及以上数据中心PUE降低到1.3以下,我国绿色数据中心发展政策也指出,将计划降低数据中心能耗总体水平

算力需求井喷,数据中心作为承载数据的关键,为我国数字经济的高质量发展提供了重要驱动力,而促进数据中心的绿色低碳和可持续发展也已成为“不可逆”的大趋势。液冷技术凭借其在制冷方面节能降碳的突出优势,成为数据中心建设的重要选择。中国移动、中国电信、中国联通在此前发布的《电信运营商液冷技术白皮书》(以下简称《白皮书》)中倡议,业界应携手解决当前液冷技术和产品接口规范标准不够完善、原创技术不够成熟、产业生态不够健全等系列问题。随着我国数字经济转向深化应用、规范发展、普惠共享的新阶段,电信运营商将逐渐成为液冷生态的主导者、设计者、构筑者,推进液冷产业生态逐渐成熟。正和铝业为您提供液冷 ,欢迎您的来电!

液冷主要指的是利用液体替代空气,带走CPU、芯片组、内存条以及扩展卡等发热器件运行时产生的热量。液冷能够为数据中心中的IT设备散热制冷,实现数据中心正常运行。数据中心(DataCenter,简称DC),即为集中放置的电子信息设备提供运行环境的建筑场所,包括主机房、辅助区、支持区和行政管理区等。作为人工智能、5G、云计算、工业互联网的底层算力基础设施,数据中心的价值大幅凸显。组成数据中心的基础设施包括服务器、光模块等IT设备及电源、制冷、机柜等非IT设备。制冷系统是数据中心基础设施的重要组件。数据中心中IT设备的器件为半导体器件,IT设备运行将会持续发热,因此需要制冷系统进行散热制冷以保证数据中心内部环境的稳定,实现数据中心的正常运行。其中制冷系统采用的冷却技术就包含液冷冷却。哪家公司的液冷口碑比较好?安徽电池液冷厂家供应

哪家公司的液冷有售后?北京电池液冷供应商

基于换热的原理,换热量的大小由有效换热面积、表面流速、换热对数温差所决定,因此在其他条件相差不大的情况下,浸没式液冷接触换热面积较大,对于表面流速(速度越高泵功率越大)、换热对数温差要求(要求更大的换热器)方面都会有明显优势。浸没式液冷就是将IT设备完全浸没在冷却液体里实现散热的技术。如图1所示,浸没式液冷系统结构简单,省掉了压缩机等制冷系统主要部件,省去了原来水冷风冷系统中两次空气与水交换的过程,且系统采用液体充分接触交换的方式,因此很容易实现单机柜100kW 的换热,并实现较低功耗(换热量大,因此需求的流速低,泵功耗低),冷却部分PUE可达1.04。北京电池液冷供应商