商机详情 -

广东进口数据分析工具

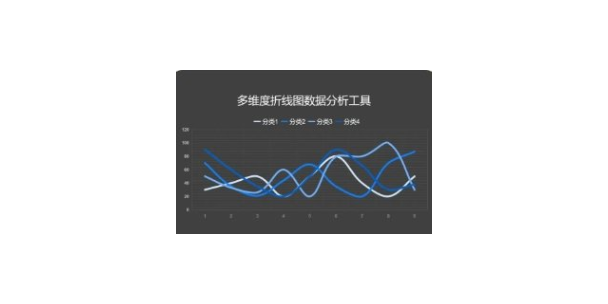

数据分析过程的主要活动由识别信息需求、收集数据、分析数据、评价并改进数据分析的有效性组成。 [6]识别需求识别信息需求是确保数据分析过程有效性的首要条件,可以为收集数据、分析数据提供清晰的目标。识别信息需求是管理者的职责管理者应根据决策和过程控制的需求,提出对信息的需求。就过程控制而言,管理者应识别需求要利用那些信息支持评审过程输入、过程输出、资源配置的合理性、过程活动的优化方案和过程异常变异的发现。。数据分析是有专门的平台软件的。广东进口数据分析工具

分析,是指将一个整体分成单独的部分以供单独检查。数据分析,是获取原始数据,然后将其转换为对用户决策有用的信息的过程。收集和分析数据以回答问题、检验假设或反驳理论。统计学家JohnTukey在1961年将数据分析定义为:分析数据的程序、解释此类程序结果的技术、计划收集数据以使其分析更容易、更精确或更准确的方法,以及适用于分析数据的(数学)统计的所有机制和结果。有几个阶段可以区分,如下所述。这些阶段是迭代的,因为来自后期阶段的反馈可能会导致早期阶段的额外工作。用于数据挖掘的CRISP框架具有类似的步骤。什么数据分析工具分类公司的福利待遇很不错的。

控制流分析跟踪程序可能执行的路径,数据流分析沿着可能的控制流路径跟踪数据可能的定义和使用,并收集有关特定数据项属性的信息。从根本上来说,数据流分析的目的是确定路径谓词的真或假。路径谓词是一些语句,这些语句表示在程序执行当中沿着一定的控制流路径发生了什么,在所有这些路径上使用任意或存在量词对语句进行量化。路径的定义与CFG有关,一条控制流路经是在CFG中的一条路径。数据流分析包括过程内的和过程间的数据流分析。常见的过程内数据流问题包括:到达定值,活跃使用,可用表达式和频繁使用,可用表达式和频繁使用。过程间数据流问题包括:形式边界 ,可能别名和可能被修改。另外,过程内的数据流问题在过程间数据流分析中也会出现。

数据流分析是一项编译时使用的技术,它能从程序代码中收集程序的语义信息,并通过代数的方法在编译时确定变量的定义和使用。通过数据流分析,可以不必实际运行程序就能够发现程序运行时的行为,这样可以帮助大家理解程序。数据流分析被用于解决编译优化、程序验证、调试、测试、并行、向量化和片行编程环境等问题。控制流图理解数据流分析的一个预备概念是控制流图(control flow graph,简称CFG),简而言之就是流图。CFG是一个有向图,它包含一部分程序的控制流。CFG典型的应用是 类似过程大小的程序片断。 [1]典型的流图结点是基本块(总是顺序执行的代码片断),流图的边 基本块之间可能存在的控制流,其中的一个结点被标明为开始。这家公司未来发展如何

生存分析(Survival analysis)Kaplan–Meier、Nelson–Aalen、Cox回归(弱性)、参数模式(弱性)、危险比例测试、时间共变项、左-右检查、韦柏分配、指数分配…流行病学工具(Tools for epidemiologists)比例标准化、病例控制、已配适病例控制、Mantel – Haenszel,药理学、ROC分析、ICD-9-CM时间序列(Time series)ARIMA、ARCH/GARCH、VAR、Newey–West、correlograms、periodograms、白色 - 噪音测试、 小整数根检定、时间序列运算、平滑化 大概似法(Maximum likelihood)转换及常态检定(Transforms and normality tests)Box–Cox、次方转换Shapiro–Wilk、Shapiro–Francia检定其它统计方法(Other statistical methods)样本数量及次方、非线性回归、逐步式回归 、统计及数学函数包含样本范例(Sample session)再抽样及模拟方法(Resampling and simulation methods)bootstrapping、jackknife、蒙地卡罗模拟、排列检定网络功能安装新指令、网络升级、网站档案分享、Stata 新消息epiman论坛学习资源丰富,学术氛围良好,在国内新生代公共卫生学术界有一定影响力。是探讨Stata、spss、sas、epidata等统计软件的主流论坛之一。数据的分析是为了更好地数据运用处理。工程数据分析工具24小时服务

都可以实时观察和跟进的。广东进口数据分析工具

初获得的数据必须经过处理或组织以供分析。 例如,这些可能涉及将数据放入表格格式(称为结构化数据)的行和列中以供进一步分析,通常是通过使用电子表格或统计软件。处理和组织后,数据可能不完整、包含重复项或包含错误。 数据清理的需要将源于数据输入和存储方式的问题。 数据清洗就是防止和纠正这些错误的过程。常见任务包括记录匹配、识别数据的不准确性、现有数据的整体质量、重复数据删除和列分割。 此类数据问题也可以通过各种分析技术来识别。 例如; 对于财务信息,可以将特定变量的总数与被认为可靠的单独发布的数字进行比较。 也可能会审查高于或低于预定阈值的异常数量。 有几种类型的数据清理,这取决于集 中的数据类型; 这可能是电话号码、电子邮件地址、雇主或其他值。 用于离群值检测的定量数据方法可用于去除似乎输入错误的可能性更高的数据。 文本数据拼写检查器可用于减少打错字的数量。 然而,很难判断这些词本身是否正确。广东进口数据分析工具

上海荟安信息技术有限公司是一家有着先进的发展理念,先进的管理经验,在发展过程中不断完善自己,要求自己,不断创新,时刻准备着迎接更多挑战的活力公司,在上海市等地区的数码、电脑中汇聚了大量的人脉以及**,在业界也收获了很多良好的评价,这些都源自于自身的努力和大家共同进步的结果,这些评价对我们而言是比较好的前进动力,也促使我们在以后的道路上保持奋发图强、一往无前的进取创新精神,努力把公司发展战略推向一个新高度,在全体员工共同努力之下,全力拼搏将共同上海荟安信息技术供应和您一起携手走向更好的未来,创造更有价值的产品,我们将以更好的状态,更认真的态度,更饱满的精力去创造,去拼搏,去努力,让我们一起更好更快的成长!